chatgpt现在可以用了吗 chatgpt真的很牛吗

淘宝搜:【红包到手500】领超级红包,京东搜:【红包到手500】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

1. 很多人不理解LLM(Large Language Model,大型语言模型)常识。不好记,可以叫它“老流氓”,有时确实是个撒谎毫无心理压力的老流氓。它是NLP(自然语言处理)领域的,处理的是人类社会产生的Natural Language,自然语言,而不是特别生成的规整的语言。按严格规矩写的语言,例如程序代码,处理成机器码叫“编译”,容易解决。

2. 人类自然语言天马行空,什么都可能聊,要理解真的很困难。所以ChatGPT能和人流畅地对话,还不跑题,真的很厉害。有人说,被我抓到了,ChatGPT编造事实了。这不是弱点,反而说明它有突破,没有相关数据事实,也编内容顶上。如果聊得像个弱智,就是算法失败。像高明的骗子,就是成功。能伪装,不弱智,是很强大的本质突破。

3. GPT等LLM是如何做到和人流畅交流的?这就涉及到它的模型原理。我们眼里的世界是物理的,LLM不是,它的世界只有几十万上百万个“token”。这些token就是语言的基本单元,是单词,也可能是词根,如teacher,可能是teach和er两个token。标点符号也是token。一个很大误解是,说ChatGPT有中文版、英文版,其实不是,就一个版本。中文英文都是token一起训练了,本来中文资料里就混了不少英文。各国语言都包进去,训练完了自动有翻译能力。但是各国语言的训练素材数量是很不同的,如ChatGPT的英语素材多,中文素材少,中文问答编造撒谎就多。文心一言就是中文素材多,英文素材少,其它语言素材还没有。

4. 那ChatGPT是怎么看待这几十万个token的?很简单,就是在这些基本单元之间,建立复杂又有逻辑的关联。例如“饕餮”,凡是出了“饕”后面必然是“餮”,这是一种极强的关联。还可以在大的约束下,有复杂一些的关联,如在古诗条件下,建立一些对偶关系。以前作诗机是人们主动整理,来建立这些关系。关联会有很多层,单词对单词,结构对单词,结构对结构,上下文关联。现在都是拿素材来训练,神经网络学习,自动整理出谁也搞不明白的复杂约束关联了。可以说LLM就是Pre-Trained,预先训练好的,记录了token之间的复杂关联,而这就是LLM的核心能力。承载关联的数据结构叫Transfomer。让它干的任务是生成语言,所以GPT就是Generatichatgptmer。

5. GPT意想不到的突破是,参数多到几千亿个之后,LLM似乎真的把语言的内核学会了,什么都“通”了,关联建立得很不错了,聊什么都知道!这就是量变到质变的“涌现”。其实它没有人类世界的知识,知道的只是一些token的关联办法。但是真很厉害,为了聊天开发的,翻译比专门的翻译模型还厉害。

6. 虽然GPT明白了人类语言的关联内核,但是和人的对话还是有些困难,因为它说的可能人类不习惯。于是OpenAI就加上了RLHF,强化学习,Human Feedback,人类反馈帮助下学习。这样,GPT就学会了讨好人类对话习惯,成了ChatGPT,等于有干货,也知道怎么说出来让人好接受了,也知道人类问的是什么。

7. 人类对LLM说的,就是一些Promt,当输入放到神经网络里算,就会输出一个词。然后把这个词也当输入,再输出一个词,最后就不断吐词。也可以叫它“吐词机”。这个能力是核心,至于做算术什么的,要补充别的模块。不能要求LLM核心懂语言以外的知识,肯定不行的。但是现在开发要求就是得会,得加别的模块。

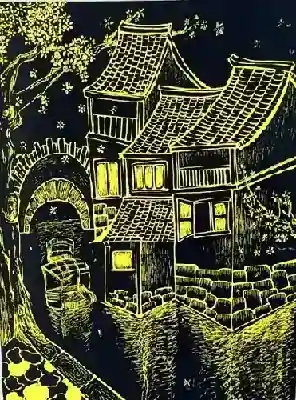

8. 例如画图,看懂输入图片,那是外加了别的模块。如看图理解模块,看词绘图模块,都有专门研究的算法。看图理解,就等于有了Prompt,就生成合适的对话输出就行了。图为文心一言生成的两副画。

ChatGPT带来的惊喜与焦虑 关于chatgpt的争论

chatgpt,chatgpt是什么意思,chatgpt官网,chatgpt国内能用吗“ChatGPT是基于OpenAI GPT-3语言模型的自然语言生成平台。”

你为什么相信上面的说法?一个简单的答案是,您信任本文的作者(或者编辑)。我们无法核实所有被告知的事情,所以我们经常相信朋友、陌生人、“专家”和机构的证词。

相信某人可能并不总是相信他们所说的是真的主要原因。(例如,我可能已经知道你告诉我什么了。)但是,我们信任说话者的事实给了我们额外的动力去相信他们所说的话。

因此,人工智能聊天机器人提出了关于信任和证词的有趣问题。我们必须考虑是否相信像ChatGPT这样的自然语言生成器告诉我们的东西。另一个问题是,这些人工智能聊天机器人是否值得信赖。

假如你告诉我外面在下雨。根据哲学家看待证词的一种方式,只有当我有理由认为你的证词是可靠的――例如,你只是在外面――而没有压倒一切的理由认为它不是可靠的时候,我才有理由相信你。这就是所谓的证言还原论。

这种观点使得合理的信念――我们认为有资格持有的假设――难以获得。

但根据证词的另一种观点,只要我没有理由认为这个陈述是错误的,我就有理由相信外面正在下雨。这使得通过证言得到的信仰更容易获得。这被称为证词的非简化理论。

请注意,这两种理论都不涉及对说话者的信任。我和他们的关系是依赖,而不是信任。

当我依赖某人或某事时,我会预测它会按照我的期望去做。例如,我依靠我的闹钟在我设定的时间响起,我依靠其他司机遵守道路规则。

然而,信任不仅仅是依赖。为了说明这一点,让我们对比一下我们对错位的信任和错位的依赖的反应。

如果我在度假时信任罗克西给我的获奖郁金香浇水,而她却不小心让它们死去,我可能会感到被背叛。然而,如果我依靠自动洒水器给郁金香浇水,但它没有启动,我可能会感到失望,但感觉被背叛是错误的。

换句话说,信任让我们容易受到背叛,所以在某种程度上,值得信赖在道德上是重要的,而可靠则不是。

信任和依赖之间的区别突出了关于证词的一些重要问题。当一个人告诉别人今天下雨时,他们不仅仅是在分享信息;他们正在为他们所说的真实性负责。

在哲学上,这被称为证明的保证理论。说话者向听者提供了一种保证,即他们所说的是真实的,这样做也给了听者一个相信他们的理由。我们相信说话的人,而不是依赖他们说出真相。

如果我发现你在猜测下雨,但幸运地猜对了,我仍然会觉得我的信任被辜负了,因为你的“保证”是空的。确信方面也有助于理解为什么在道德上,谎言似乎比虚假陈述更糟糕。在这两种情况下,你先是让我信任你,然后又辜负了我的信任,谎言试图利用我的信任来反对我,从而促成背叛。

如果保证的观点是正确的,那么ChatGPT需要能够为它所说的负责任,以便成为一个值得信赖的演讲者,而不仅仅是可靠。虽然我们似乎可以明智地将代理属性赋予人工智能,以执行所需的任务,但人工智能是否可以成为道德上负责任的代理完全是另一个问题。

一些哲学家认为道德能动性并不局限于人类。其他人则认为,人工智能不能承担道德责任,因为,举几个例子,它们没有精神状态,缺乏自主性,或缺乏道德推理的能力。

然而,ChatGPT不是道德代理;它不能为自己的言论负责。当它告诉我们一些事情时,它并不保证它的真实性。这就是为什么它可以给出虚假陈述,但不能说谎。构建chatgpt的openai在其网站上表示,由于人工智能是根据来自互联网的数据进行训练的,因此它“有时可能不准确、不真实,甚至具有误导性”。

充其量,它是一个“真相测量器”或事实核查员――而且很多人认为,它并不是一个特别准确的人。虽然我们有时可能有理由相信它所说的,但我们不应该相信它。

如果您想知道,本文的开头引用了ChatGPT在我问它“什么是ChatGPT?”时的回答摘录。所以你不应该相信这个说法是真的。然而,我可以向你保证它是。由The Conchatgpt提供

本文转载自The Co在创作共用许可下的对话。阅读原文。

引用: ChatGPT不会对你撒谎,但你仍然不应该相信它,哲学家(2023,3月10日)从【【网址】】/news/2023-03-chatgpt-shouldnt-philosopher.html这个文档中检索到2023年3月13日 作品受版权保护。除为私人学习或研究目的而进行的公平交易外,未经书面许可,不得转载任何部分。的有限公司 Ntent仅供参考之用。 点击分享到